Matteo Pasquinelli*

**Tomado de e – flux Journal #14, dic. 2023

*** Traducción: Guillermo Vanegas + ChatGPT 3,5 + Google Translate

La automatización de la psicometría o la inteligencia general

La división del trabajo tanto como el diseño de máquinas y algoritmos, no es una forma abstracta per se sino un medio para medir el trabajo y los comportamientos sociales y diferenciar a las personas según su capacidad productiva. Como indican los principios de Babbage, cualquier división del trabajo implica una métrica: una medición de la performatividad y eficiencia de los trabajadores, pero también un juicio sobre las clases de habilidades, lo que implica una jerarquía social implícita. Métricas del trabajo han sido introducidas para evaluar lo que es y no es productivo, para manipular una asimetría social y al mismo tiempo declarar una equivalencia con el sistema monetario. Durante la edad moderna, fábricas, cuarteles y hospitales han seguido una disciplina y organización de cuerpos y mentes con métodos similares, como lo intuyó, entre otros, Michel Foucault.

A finales del siglo XIX, la metrología del trabajo y las conductas encontró un aliado en un nuevo campo de la estadística: la psicometría. Ésta tenía como objetivo medir las habilidades de la población para resolver tareas básicas, haciendo comparaciones estadísticas en pruebas cognitivas en lugar de tomar medidas del rendimiento físico como en el campo anterior de la psicofísica.(1) Como parte del controvertido legado de Alfred Binet, Charles Spearman y Louis Thurstone, la psicometría puede considerarse una de las principales genealogías de la estadística que nunca ha sido una disciplina neutral sino más bien preocupada por la «medida del hombre», la institución de normas de conducta y la represión de anormalidades.(2) La transformación de la métrica del trabajo en psicometría del trabajo es un paso clave tanto para la gestión como para el desarrollo tecnológico en el siglo XX. Resulta revelador que al diseñar el primer perceptrón de red neuronal artificial, Frank Rosenblatt no sólo se inspiró en las teorías de la neuroplasticidad sino también en las herramientas de análisis multivariable que la psicometría importó a la psicología estadounidense en los años cincuenta.

Desde esta perspectiva, este libro ha intentado aclarar cómo el proyecto de la IA surgió en realidad de la automatización de la psicometría de las conductas laborales y sociales y no de los intentos por resolver el «enigma» de la inteligencia. En un resumen conciso de la historia de la IA, se podría decir que la mecanización del «intelecto general» de la era industrial en la «inteligencia artificial» del siglo XXI fue posible gracias a la medición estadística de las habilidades, tal como el factor de «inteligencia general» de Spearman y su posterior automatización en redes neuronales artificiales. Si en la era industrial la máquina se consideraba una encarnación de la ciencia, el conocimiento y el «intelecto general» de los trabajadores, en la era de la información las redes neuronales artificiales se han convertido en las primeras máquinas en codificar la «inteligencia general» en herramientas estadísticas —al principio, específicamente, automatizando el reconocimiento de patrones como una de las tareas clave de la «inteligencia artificial». En resumen, la forma actual de IA, el aprendizaje automático, es la automatización de las métricas estadísticas que se introdujeron originalmente para cuantificar las capacidades cognitivas, sociales y laborales. La aplicación de la psicometría a través de las tecnologías de la información no es un fenómeno exclusivo del aprendizaje automático. El escándalo de datos de Facebook de 2018 (3), en que la consultora recopiló los datos personales de millones de personas sin su consentimiento, es un recordatorio de cómo los actores corporativos y estatales utilizan la psicometría a gran escala en un intento de predecir y manipular comportamientos colectivos.(4)

Dado su legado en las herramientas estadísticas de la biometría del siglo XIX, tampoco sorprende que las redes neuronales artificiales profundas se hayan convertido recientemente en técnicas avanzadas de vigilancia (reconocimiento facial, análisis de patrones de vida). Académicos críticos de la IA como Ruha Benjamin y Wendy Chun, han expuesto los orígenes racistas de estas técnicas de identificación y elaboración de perfiles que, como la psicometría, representan una prueba técnica del sesgo social de la IA.(5) Han identificado acertadamente el poder de la discriminación en el núcleo del aprendizaje automático y cómo se alinea con los aparatos de normatividad de la era moderna, incluidas las cuestionables taxonomías de la medicina, la psiquiatría y el derecho penal.(6)

La metrología de la inteligencia, pionera hacia finales del siglo XIX con su agenda de segregación social y racial, todavía opera en el núcleo de la IA para disciplinar el trabajo y replicar jerarquías productivas de conocimiento. Por lo tanto, la razón fundamental de la IA no es solo la automatización del trabajo sino el refuerzo de estas jerarquías de manera indirecta. Al declarar implícitamente qué se puede automatizar y qué no, la IA ha impuesto nuevas métricas de inteligencia en cada etapa de su desarrollo. Pero comparar la inteligencia humana y la de las máquinas implica también un juicio sobre qué comportamiento humano o grupo social es más inteligente que otro, qué trabajadores pueden ser reemplazados y cuáles no. En última instancia, la IA no es sólo una herramienta para automatizar el trabajo, sino también para imponer estándares de inteligencia mecánica que propagan, de manera más o menos invisible, jerarquías sociales de conocimiento y habilidades. Como ocurre con cualquier forma anterior de automatización, la IA no simplemente reemplaza a los trabajadores también los desplaza y reestructura en un nuevo orden social.

La automatización de la automatización

Observando detenidamente cómo las herramientas estadísticas concebidas para calificar las habilidades cognitivas y discriminar entre la productividad de las personas se convirtieron en algoritmos, se hace evidente un aspecto más profundo de la automatización. De hecho, el estudio de la metrología del trabajo y de los comportamientos revela que la automatización surge, en algunos casos, de la transformación de los propios instrumentos de medida en tecnologías cinéticas. Las herramientas para la cuantificación del trabajo y la discriminación social se convirtieron en «robots» por derecho propio. Antes de la psicometría, se podría hacer referencia a cómo Babbage implementó el reloj utilizado para medir el tiempo de trabajo en la fábrica para la automatización del trabajo mental en el motor diferencial. Cibernéticos como Norbert Wiener consideraban el reloj como un modelo clave tanto para el cerebro como para el ordenador. En este sentido, el historiador de la ciencia Henning Schmidgen ha señalado cómo la cronometría de los estímulos nerviosos contribuyó a la consolidación de la metrología cerebral y también del modelo de redes neuronales de McCulloch y Pitts.(7) La teoría de la automatización que este libro ha ilustrado, entonces, no apunta sólo al surgimiento de las máquinas a partir de la lógica de la gestión laboral sino también de los instrumentos y métricas para cuantificar la vida humana en general y hacerla productiva.

Este libro ha buscado mostrar que la IA es la culminación de la larga evolución de la automatización laboral y la cuantificación de la sociedad. Los modelos estadísticos de aprendizaje automático no parecen, de hecho, radicalmente diferentes del diseño de las máquinas industriales sino, más bien, homólogos a ellas: de hecho, están constituidos por la misma inteligencia analítica de tareas y comportamientos colectivos, aunque con un mayor grado de complejidad (por ejemplo, en el número de parámetros). Al igual que las máquinas industriales cuyo diseño surgió gradualmente a través de tareas rutinarias y ajustes de prueba y error, los algoritmos de aprendizaje automático adaptan su modelo interno a los patrones de los datos de entrenamiento mediante un proceso comparable de prueba y error. Se puede decir que el diseño de una máquina y el modelo de un algoritmo estadístico siguen una lógica similar: se basan en la imitación de una configuración externa de espacio, tiempo, relaciones y operaciones. En la historia de la IA, esto fue tan cierto para el perceptrón de Rosenblatt (cuyo objetivo era registrar los movimientos de la mirada y las relaciones espaciales del campo visual) como para cualquier algoritmo de aprendizaje automático actual (por ejemplo, máquinas de vectores de soporte, redes bayesianas, modelos de transformadores).

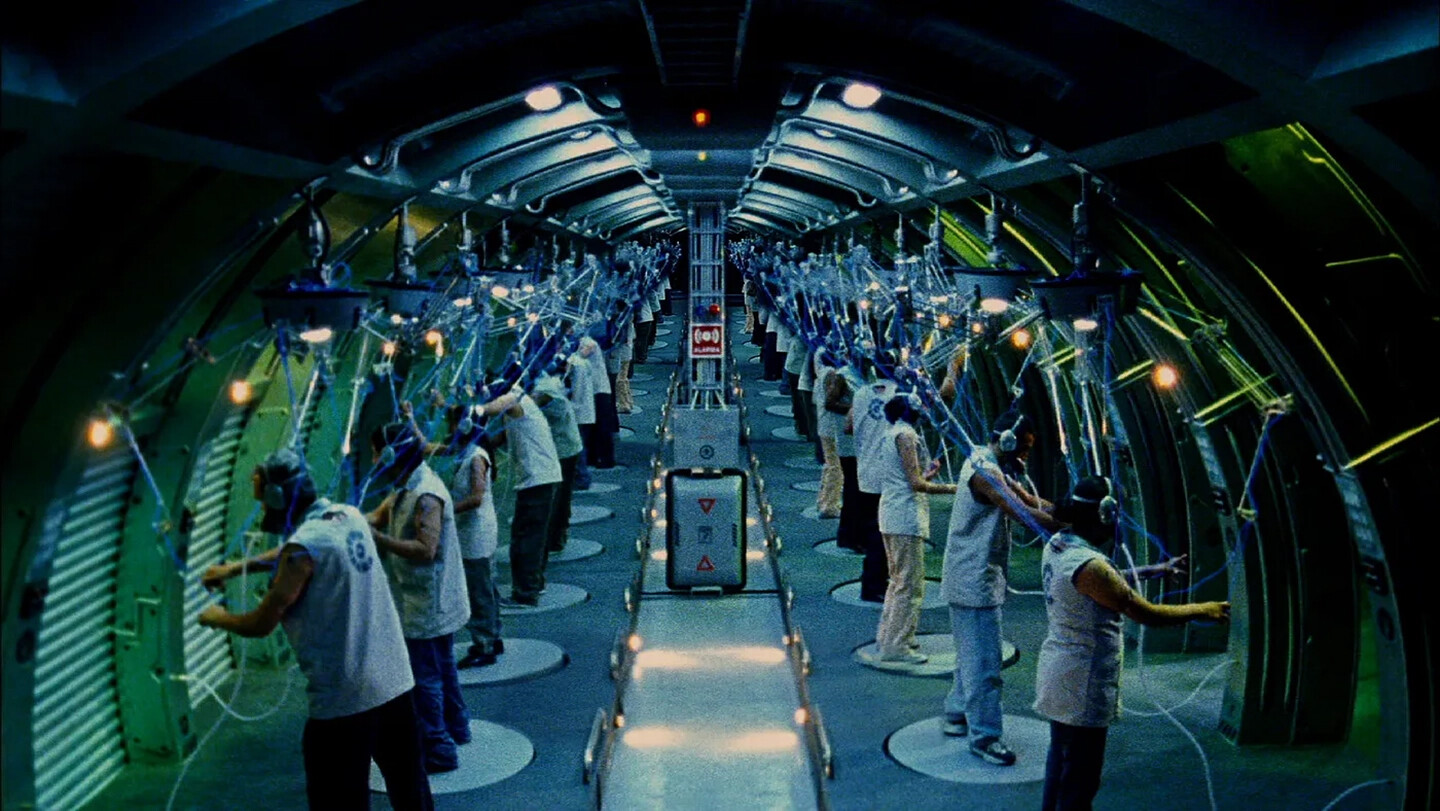

Mientras la máquina industrial encarna el diagrama de la división del trabajo de determinada manera (pensemos en los componentes y «grados de libertad» limitados de un telar textil, un torno o una excavadora), los algoritmos de aprendizaje automático (especialmente los recientes modelos de IA con una gran cantidad de parámetros) pueden imitar actividades humanas complejas. (8) Aunque con niveles problemáticos de aproximación y sesgo, un modelo de aprendizaje automático es un artefacto adaptativo que puede codificar y reproducir las más diversas configuraciones de tareas. Por ejemplo, un mismo modelo de aprendizaje automático puede emular el movimiento de brazos robóticos en líneas de montaje tanto como las operaciones del conductor en un vehículo autónomo; el mismo modelo puede traducir entre idiomas y describir imágenes con palabras coloquiales.

El auge en los últimos años de los grandes modelos básicos (BERT, GPT, CLIP, Codex) demuestra cómo se puede entrenar un único algoritmo de aprendizaje profundo en un vasto conjunto de datos integrado (que comprende texto, imágenes, voz, datos estructurados y señales 3D) y se utiliza para automatizar una amplia gama de las llamadas tareas posteriores (respuesta de preguntas, análisis de sentimientos, extracción de información, generación de texto, subtítulos de imágenes, generación de imágenes, transferencia de estilo, reconocimiento de objetos, seguimiento de instrucciones, etc.). (9) Por la forma en que se han construido —sobre grandes depósitos de patrimonio cultural, conocimiento colectivo y datos sociales—, estos modelos son la aproximación más cercana a la mecanización del «intelecto general» que se imaginó en la era industrial. Un aspecto importante del aprendizaje automático que demuestran los modelos básicos es que la automatización de tareas individuales, la codificación del patrimonio cultural y el análisis de comportamientos sociales carecen de distinción técnica: pueden realizarse mediante un mismo proceso de modelado estadístico.

En conclusión, el aprendizaje automático puede verse como un proyecto para automatizar el proceso mismo de diseño de máquinas y fabricación de modelos, es decir, la automatización de la propia teoría laboral de la automatización. En este sentido, el aprendizaje automático y, específicamente, los grandes modelos representan una nueva definición de Máquina Universal, ya que su capacidad no solo sirve para realizar tareas computacionales sino para imitar comportamientos laborales y colectivos en general. Por lo tanto, el avance que el aprendizaje automático ha llegado a representar no es sólo la «automatización de las estadísticas», como a veces se describe el aprendizaje automático, sino la automatización de la automatización, llevando este proceso a la escala del conocimiento colectivo y el patrimonio cultural. (10) Además, el aprendizaje automático puede considerarse como la prueba técnica de la integración gradual de la automatización laboral y la gobernanza social. Surgiendo de la imitación de la división del trabajo y la psicometría, los modelos de aprendizaje automático han evolucionado gradualmente hacia un paradigma integrado de gobernanza que el análisis de datos corporativos y sus vastos centros de datos ejemplifican bastante bien.

Notas

1.- La palabra «estadística» se refería originalmente al conocimiento que poseía el Estado sobre sus propiios asuntos y territorios: un conocimiento que debía permanecer secreto. Michel Foucault, Security, Territory, Population: Lectures at the Collège de France 1977–1978, trans. Graham Burchell (Palgrave Macmillan, 2009), 274.

2.- Sobre la influencia de la metrología en la historia de la IA, véase Simon Schaffer, «Judgements that machines are intelligent have involved techniques for measuring brains’ outputs. These techniques show how discretionary behavior is connected with the status of those who rely on intelligence for their social legitimacy»,en Schaffer, «OK Computer», Ansichten der Wissenschaftsgeschichte, ed. Michael Hagner (Fischer, 2001). Sobre la metrología temprana del sistema nervioso: Henning Schmidgen, The Helmholtz Curves: Tracing Lost Times (Fordham University Press, 2014).

3.- Convenientemente redirigido contra y rebautizado con el nombre de la empresa encargada de gestionar el espionaje de la red social: Cambridge Analytica (N. d. T.)

4.- Luke Stark, «Algorithmic Psychometrics and the Scalable Subject», Social Studies of Science 48, no. 2 (2018).

5.- Ruha Benjamin, Race after Technology: Abolitionist Tools for the New Jim Code (Polity, 2019); Wendy Chun, Discriminating Data: Correlation, Neighborhoods, and the New Politics of Recognition (MIT Press, 2021).

6.- Sobre la imbricación de colonialismo, racismo y tecnologías digitales, véase Jonathan Beller, The World Computer: Derivative Conditions of Racial Capitalism (Duke University Press, 2021); Seb Franklin, The Digitally Disposed: Racial Capitalism and the Informatics of Value (University of Minnesota Press, 2021).

7.- Henning Schmidgen, «Cybernetic Times: Norbert Wiener, John Stroud, and the “Brain Clock”Hypothesis», History of the Human Sciences 33, no. 1 (2020). Sobre cibernética y la «medida de la racionalidad», véase Orit Halpern, Beautiful Data: A History of Vision and Reason since 1945 (Duke University Press, 2015), 173.

8.- En mecánica, los grados de libertad (DOF, en inglés) de sistemas como una máquina, un robot o un vehículo son el número de parámetros independientes que definen su configuración o estado. Se dice usualmente que las bicicletas poseen dos DOF. Un brazo robótico puede tener muchos más. Un modelo de aprendizaje automático, como GPT, puede alcanzar más del trillón.

9.- Rishi Bommasani et al., On the Opportunities and Risks of Foundation Models, Center for Research on Foundation Models at the Stanford Institute for Human-Centered Artificial Intelligence, 2021.

10.- Para una lectura distinta sobre la automatización de la automatización, véase Pedro Domingos, The Master Algorithm: How the Quest for the Ultimate Learning Machine Will Remake Our World (Basic Books, 2015); Luciana Parisi, «Critical Computation: Digital Automata and General Artificial Thinking», Theory, Culture, and Society 36, no. 2 (March 2019).

*Profesor asociado de filosofía de la ciencia en el Departamento de filosofía y herencia cultural de la universidad Ca’ Foscari (Venecia). Allí coordina el proyecto ERC AIMODELS. Escribió la monografía The Eye of the Master: A Social History of Artificial Intelligence (Verso, 2023), de donde se toma este extracto.